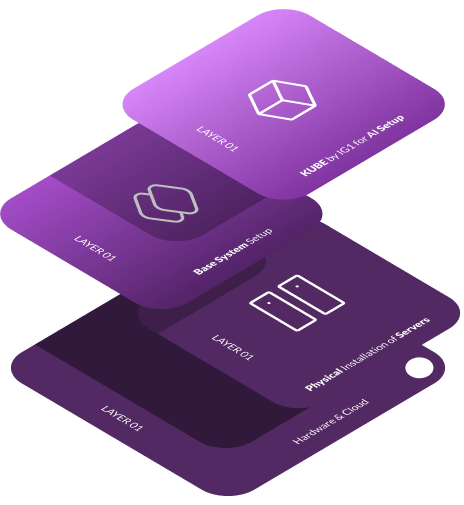

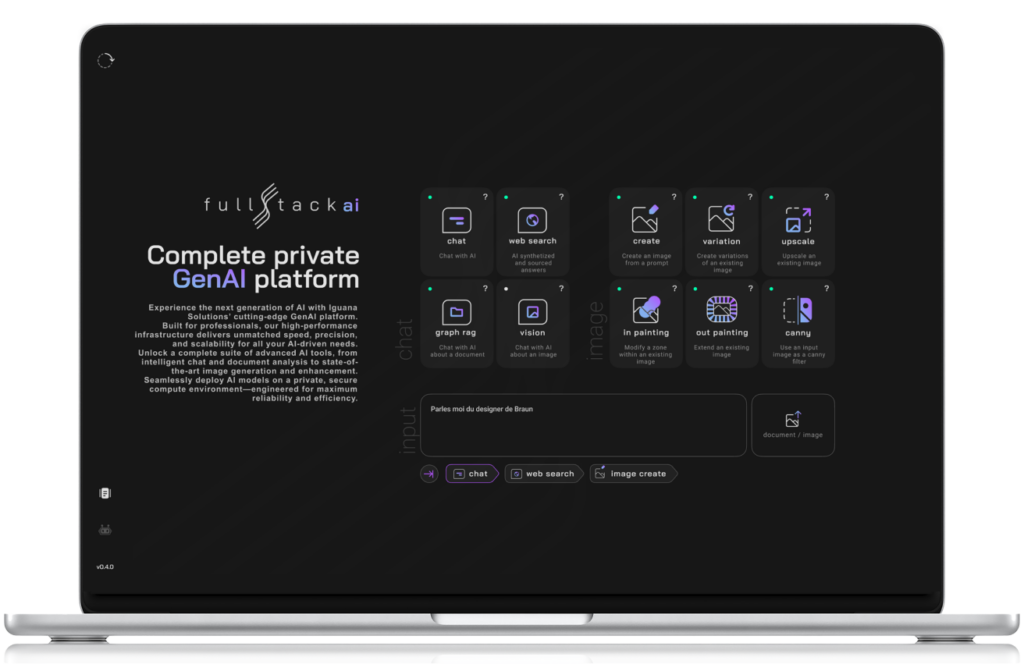

Une solution complète pour l'infrastructure de l'IA

Notre plateforme d'IA complète, conçue avec des solutions matérielles et logicielles, est construite pour fournir une intégration transparente, offrant une pile complète prête à être déployée sur site ou dans le cloud. Des puissants GPU Nvidia et du matériel cloud, aux outils d'orchestration intelligents et aux modèles d'IA avancés, la pile d'IG1 garantit des implémentations GenAI efficaces et évolutives. Nous offrons des configurations flexibles adaptées à vos besoins, permettant un déploiement rapide et une productivité immédiate avec vos initiatives basées sur l'IA.