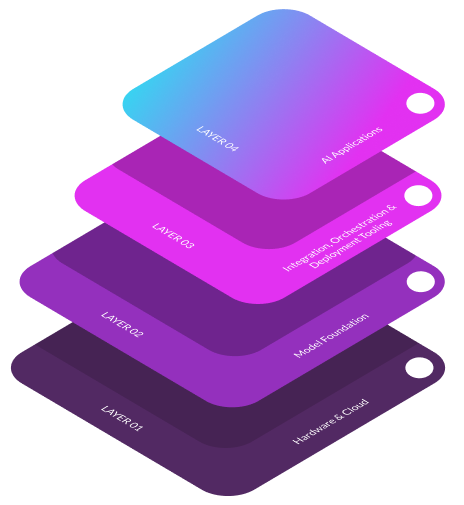

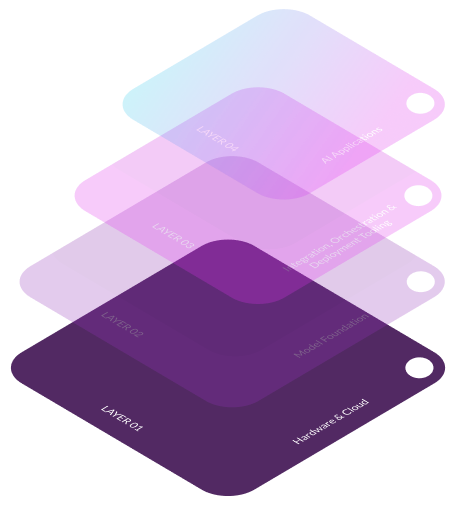

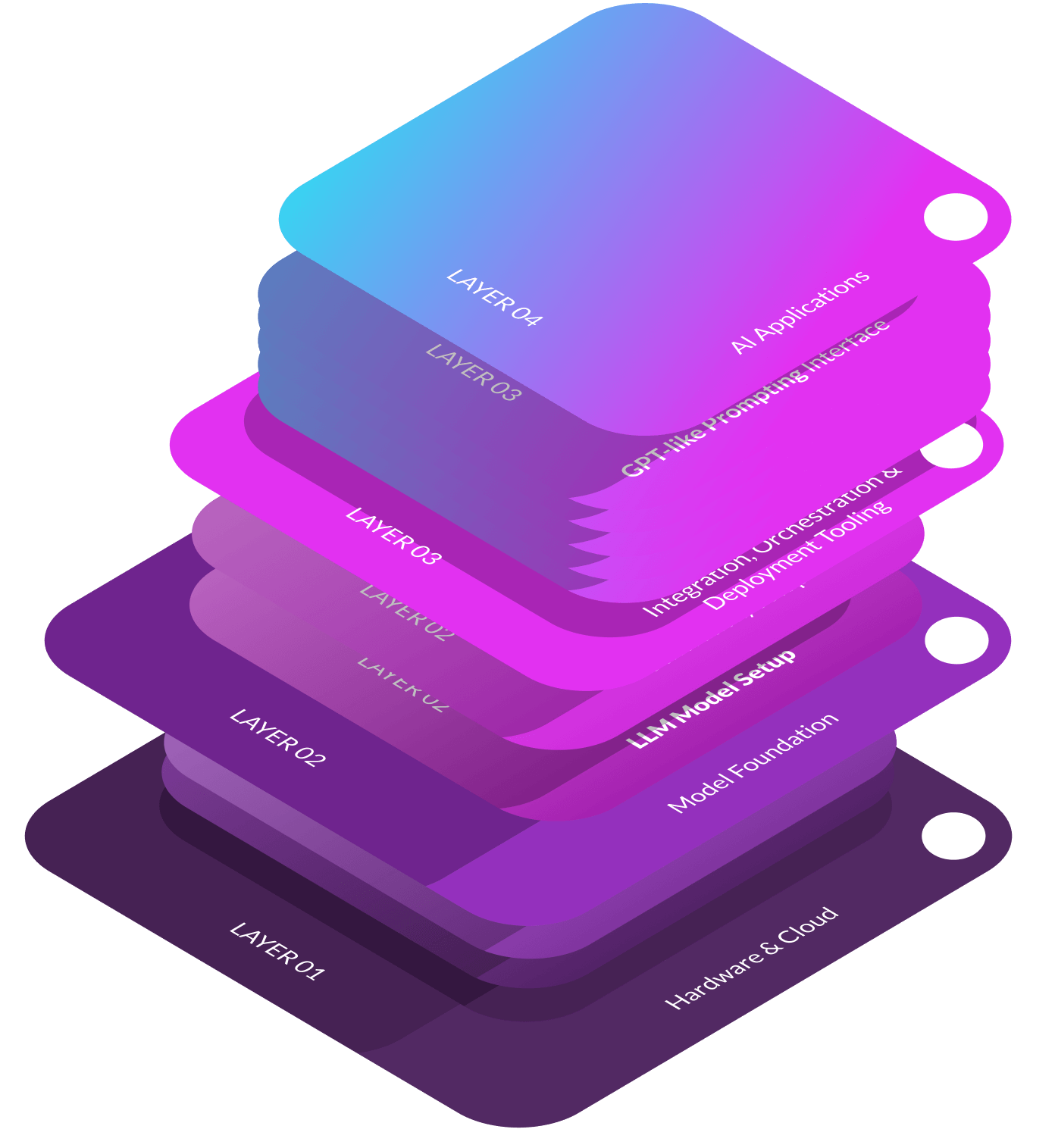

La stack de GenAI représente une architecture multicouche qui permet le développement et le déploiement de solutions d'IA sophistiquées. Au cœur de cette architecture, la stack englobe l'infrastructure matérielle et cloud , les modèles fondamentaux, les outils d'intégration et les applications destinées aux utilisateurs finaux. Chaque couche joue un rôle crucial dans la transformation des données brutes en informations exploitables et en applications innovantes. Il est essentiel de comprendre cette stack pour exploiter tout le potentiel de l'IA, depuis l'optimisation des ressources de calcul et la sélection des modèles appropriés jusqu'à leur intégration transparente dans les environnements de production. Ce guide présente une analyse détaillée de chaque couche, illustrant leur interconnexion et leur importance dans l'écosystème de l'IA.

Infrastructure matérielle et cloud constituent la couche fondamentale de l'IA générative stack, fournir la puissance de calcul et la flexibilité nécessaires à l'entraînement et au déploiement des modèles d'IA.

Cloud offre des services évolutifs et flexibles de fournisseurs tels qu'AWS, GCP et Azure, permettant une formation et un déploiement de modèles d'IA rentables et accessibles, mais peut être confrontée à des problèmes de latence et de conformité.

Le matériel, y compris les GPU comme le Nvidia H100 et le Cerebras Wafer-Scale Engine, accélère l'apprentissage et l'inférence des modèles d'IA en fournissant une puissance de calcul élevée, essentielle pour traiter efficacement de grands ensembles de données.

Il représente les modèles génératifs de base qui servent d'éléments constitutifs aux applications d'IA.. Ces modèles, tels que GPT-3, BERT et DALL-E, sont pré-entraînés sur de vastes ensembles de données, capturant des modèles et des connaissances complexes. Ils constituent un point de départ pour diverses tâches d'IA, du traitement du langage naturel (NLP) à la génération d'images..

Les modèles sont essentiels car ils permettent aux machines de comprendre, de générer et de manipuler des textes, des images et d'autres formes de données semblables à celles des humains. Leur rôle est de généraliser à partir de grandes quantités de données, en faisant des prédictions ou en générant des sorties basées sur de nouvelles entrées.. Cette couche fondamentale permet aux développeurs d'exploiter ces modèles sophistiqués sans partir de zéro, ce qui réduit considérablement le temps et les ressources.

En affinant ces modèles pré-entraînés sur des ensembles de données spécifiques, ils peuvent être adaptés à des tâches spécialisées, ce qui permet d'améliorer les performances et la précision. La couche Model Foundation est donc indispensable pour construire des solutions d'IA efficaces, évolutives et performantes.

L'outil d'intégration, d'orchestration et de déploiement est essentiel parce que il comble le fossé entre les modèles de base et les applications pratiques. Ces outils permettent aux développeurs d'intégrer des modèles génératifs dans des systèmes réels, de les adapter à des tâches spécifiques et de gérer leur déploiement à grande échelle. Sans cette couche, l'utilisation de modèles d'IA avancés serait lourde et inefficace. Elle fournit des capacités essentielles telles que le réglage rapide, l'automatisation du flux de travail et l'intégration du système, garantissant que les modèles sont non seulement efficaces, mais aussi parfaitement opérationnels dans les environnements de production. Cette couche est essentielle pour transformer les capacités théoriques de l'IA en solutions pratiques et utilisables..

Des outils tels que Dust, LangChain et Humanloop permettent une intégration, un réglage et un déploiement efficaces des modèles d'IA, rationalisant ainsi les processus de développement et améliorant les performances des modèles dans les environnements de production.

Des solutions de plateforme comme OpenAI et Cohere fournissent des API pour l'intégration transparente de modèles d'IA avancés dans les applications, facilitant ainsi l'accès à de puissantes capacités de NLP et de génération.

Il représente la mise en œuvre concrète, par l'utilisateur final, des modèles génératifs, démontrant leur valeur pratique. Ces applications, telles que les outils de génération de texte, de code, d'image et de vidéo, exploitent l'IA avancée pour automatiser les tâches, améliorer la productivité et stimuler l'innovation dans divers domaines. En présentant des utilisations concrètes de l'IA, cette section montre comment les modèles génératifs peuvent résoudre des problèmes spécifiques, rationaliser les flux de travail et créer de nouvelles opportunités. Sans cette couche, les avantages de l'IA avancée resteraient théoriques et les utilisateurs ne ressentiraient pas l'impact transformateur de ces technologies dans leur vie quotidienne.

Les applications autonomes telles que Jasper et Copy.AI utilisent indépendamment des modèles génératifs pour fournir des services spécialisés tels que la création de contenu, améliorant la productivité et la créativité sans dépendre de plateformes externes.

Des applications bolt-on comme Notion AI et GitHub Copilot intègrent des capacités d'IA dans les plateformes existantes, en améliorant leur fonctionnalité avec des fonctions telles que la génération de texte, l'automatisation des tâches et la complétion de code.

Ce guide explique comment nous avons mis en place l'infrastructure GenAI à l'aide de KUBE by IG1. Il commence par l'installation des serveurs et des GPU NVidia et la configuration des logiciels de base. Ensuite, nous configurons KUBE by IG1 pour gérer les machines virtuelles et nous assurer que tout est connecté correctement. Nous téléchargeons et optimisons le modèle d'IA LLM, l'intégrons à un système qui améliore les réponses et mettons en place des interfaces conviviales pour interagir avec l'IA. Enfin, nous testons le système en profondeur, vérifions ses performances et mettons en place des outils de surveillance pour assurer son bon fonctionnement. Cela permet d'obtenir une installation d'IA robuste et efficace.

Présentation de la plateforme IA Plug n Play d'Iguane Solutions avec un aperçu de la plateforme et de ses fonctionnalités : infrastructure, LLM & RAG, orchestrateur et supervision, chat, copilote, no-code, API...

Découvrez le témoignage du CTO d'EasyBourse sur son utilisation de la plateforme.

" Avec notre ancien partenaire, notre capacité de croissance s'était arrêtée.... Opter pour Iguane Solutions nous a permis de multiplier notre performance globale par au moins 4. "

Cyril Janssens

CTO, easybourse

Embarquez pour votre voyage DevOps avec Iguane Solutions et faites l'expérience d'une transformation qui s'aligne sur les normes les plus élevées d'efficacité et d'innovation. Notre équipe d'experts est prête à vous guider à chaque étape, de la consultation initiale à la mise en œuvre complète. Que vous cherchiez à affiner vos processus actuels ou à construire un nouvel environnement DevOps à partir de zéro, nous avons l'expertise et les outils pour y parvenir. Contactez-nous dès aujourd'hui pour planifier votre consultation gratuite ou pour en savoir plus sur la façon dont nos solutions DevOps sur mesure peuvent bénéficier à votre organisation. Laissez-nous vous aider à atteindre de nouveaux niveaux de performance et d'agilité. N'attendez pas, faites dès maintenant le premier pas vers une infrastructure plus dynamique et plus réactive.